- Ventana de contexto: 8,000 tokens

- Procesamiento multimodal: No (Solo texto)

- Costo: Gratis - con limitaciones

- Conexion a internet: No

¿Que Modelo de IA es mejor? ChatGPT vs Gemini vs Copilot vs Claude - Guia 2024

Publicado el 19 De julio del 2024

¿Quién Lleva la delantera en el mundo de la IA: Open IA, Microsoft o Google?

La inteligencia artificial y los modelos de lenguaje grande (LLM) están cambiando la forma en que interactuamos con la tecnología.

En 2024, los modelos más destacados son ChatGPT de OpenAI, Microsoft Copilot, Claude de Anthropic y Google Gemini.

En este artículo, tenemos la mision de ayudarte a elegir el mejor modelo para ti.

Nos pusimos a la tarea de compararemos sus capacidades, características, ventajas y desventajas.

También te presentaremos la ultima novedad en el mundo de la IA: el nuevo GPT-4o mini de OpenAI, para que tengas un panorama completo y actualizado sobre cada herramienta que integra el mundo de los ChatBots de Inteligencia artificial

Evaluación de modelos LLM de IA

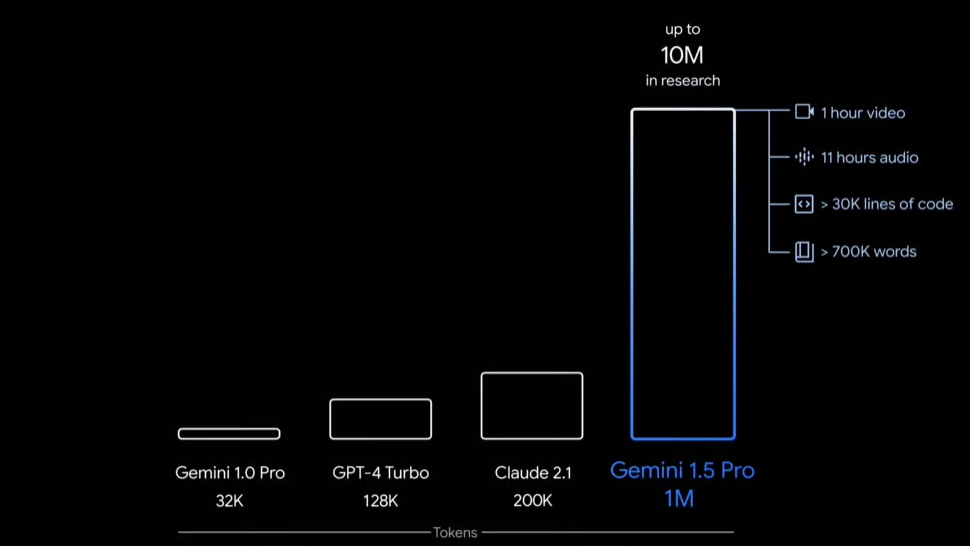

Comparacion de diferentes modelos de IA artificial con respecto a sus capacidades técnicas: Ventanas de contexto vs Tokens y multimodalidad

Parametros Técnicos

Para evaluar estos modelos, consideramos varios parámetros técnicos importantes. Aquí te explicamos algunos de ellos de manera sencilla:

Ventana de contexto: Imagina que estás leyendo un libro y puedes recordar todo lo que has leído hasta ahora. La ventana de contexto es similar, es la cantidad de información previa que un modelo puede recordar y usar al generar una respuesta. Cuanto mayor sea esta ventana, más coherente será la respuesta del modelo en textos largos.

Interacción multimodal: Esto significa que el modelo no solo entiende y genera texto, sino también imágenes y, en algunos casos, audio y video. Es como tener un asistente que puede ver y escuchar, además de leer y escribir.

Capacidad de generación de tokens: Los tokens son como las palabras y los pedacitos de las palabras que el modelo puede usar para generar respuestas. Un mayor número de tokens significa respuestas más largas y detalladas. Se calcula que en promedio, 1.000 tokens equivalen a unas 750 palabras aproximadamente.

Latencia y costo: La latencia es el tiempo que tarda el modelo en responder, y el costo es cuánto tienes que pagar para usarlo. Ambos son importantes, especialmente si necesitas respuestas rápidas y económicas.

Rendimiento en benchmarks: Estas son pruebas estándar que miden qué tan bien el modelo puede hacer ciertas tareas, como resolver problemas matemáticos o entender el lenguaje natural.

Pruebas de Benchmark

Para evaluar los modelos LLM, se utilizan varias pruebas de benchmark que proporcionan un marco riguroso para medir su rendimiento. Aquí te explicamos algunas de las más importantes:

MMLU (Massive Multitask Language Understanding): Esta prueba evalúa la capacidad del modelo para entender y responder correctamente en una variedad de tareas y dominios, desde ciencias hasta humanidades y matemáticas. Una alta puntuación en MMLU indica que el modelo puede manejar una amplia gama de temas con precisión.

HumanEval: Evalúa la capacidad del modelo para generar código correcto basado en descripciones de problemas de programación. Es crucial para determinar la utilidad del modelo en tareas de codificación y desarrollo de software.

MGSM (Mathematical Generalization and Symbolic Manipulation): Esta prueba mide la capacidad del modelo para resolver problemas matemáticos complejos y realizar manipulaciones simbólicas.

Estas pruebas ayudan a identificar las fortalezas y debilidades de cada modelo, proporcionando una visión clara de su rendimiento en diferentes áreas.

Alucinaciones en ChatBots de IA

Las alucinaciones en los modelos LLM se refieren a respuestas que parecen coherentes y creíbles, pero que son incorrectas o carecen de fundamento en los datos proporcionados. Estas pueden ser problemáticas porque pueden inducir a error a los usuarios. Es importante tener en cuenta este factor al evaluar la fiabilidad de un modelo de lenguaje.

ChatGPT de OpenAI

Capacidades y características

ChatGPT de OpenAI es conocido por mantener conversaciones naturales y generar textos relevantes. Actualmente, OpenAI ofrece cuatro versiones:

- GPT-3.5: Ideal para tareas generales, ofrece buena calidad en las conversaciones y generación de textos.

- GPT-4: La versión más avanzada, puede manejar texto e imágenes y tiene una gran capacidad para entender contextos largos.

- GPT-4o: Una versión optimizada de GPT-4, equilibrando rendimiento y costo.

- GPT-4o mini: La versión más reciente y asequible, diseñada para aplicaciones que necesitan bajo costo y baja latencia.

Ventana de contexto: Hasta 128,000 tokens.

Generación de texto: Hasta 16,000 tokens por solicitud.

Pros y contras

Pros:

- Gran capacidad para generar textos coherentes.

- Soporta texto e imágenes.

- Personalización con plugins y GPTs personalizados.

- Conexión a internet para información actualizada.

Contras:

- Limitado a 40 mensajes cada 3 horas para usuarios Plus.

- Requiere suscripción para acceder a características avanzadas.

Costo

- GPT-3.5: Gratis con limitaciones.

- GPT-4: $20/mes (suscripción Plus).

- GPT-4o: $5 por millón de tokens de entrada

- GPT-4o mini: $15 centavos de dólar por millón de tokens de entrada.

GPTs Personalizados

Los GPTs personalizados son una característica destacada de ChatGPT. Permiten a los usuarios crear versiones específicas del modelo adaptadas a necesidades particulares.

Por ejemplo, una empresa puede personalizar un GPT para manejar consultas de servicio al cliente con conocimiento profundo de sus productos y políticas.

Esto se logra ajustando el modelo con datos específicos y reglas personalizadas, mejorando así la relevancia y precisión de las respuestas.

Si deseas aprender a crear tus propios GPTs, te compartimos un blog para que aprendas a crear paso a paso tu primer GPT personalizado y un blog sobre todo lo que debes saber para publicarlo en la GPT Store de Open IA.

Lo último en el mundo de la IA: El nuevo Chat GPT-4o mini

Capacidades y características

El GPT-4o mini es el modelo más reciente y asequible de OpenAI, diseñado para hacer la inteligencia artificial más accesible. Es significativamente más económico y ofrece un rendimiento notable.

- Rendimiento: 82% en MMLU, superando a modelos como GPT-4 en preferencias de chat.

- Costo y latencia: Ideal para aplicaciones que requieren bajo costo y baja latencia.

- Capacidades multimodales: Texto, visión, y próximamente audio y video.

Pros y Contras

Pros:

- Asequible y de alto rendimiento.

- Ideal para aplicaciones en tiempo real.

- Alta capacidad de generación de tokens y manejo de contextos largos.

Contras:

- Aún en desarrollo para soportar todas las modalidades.

Microsoft Copilot

Capacidades y características

Copilot, desarrollado por Microsoft en colaboración con OpenAI, utiliza la tecnología GPT-4 y está integrado en las aplicaciones de Microsoft 365. Es gratuito y no tiene limitaciones de mensajes por día como ChatGPT.

- Multimodal: Puede manejar texto e imágenes.

- Integración con Microsoft 365: Ofrece funcionalidades mejoradas para documentos, hojas de cálculo y más.

Pros y contras

Pros:

- Uso gratuito del modelo GPT-4.

- Alta capacidad de mensajes diarios.

- Integración profunda con Microsoft 365.

Contras:

- Menos variedad de plugins comparado con ChatGPT.

- La velocidad de respuesta puede ser más lenta debido a la integración con múltiples aplicaciones.

Costo

Gratuito (incluido con suscripción a Microsoft 365).

Claude de Anthropic

Capacidades y características

Claude, de Anthropic, se destaca por su capacidad para leer, analizar y resumir archivos largos con una gran ventana de contexto de hasta 100,000 tokens.

- Enfoque en texto: Ideal para análisis y resúmenes de textos largos.

- Ventana de contexto: Amplia capacidad para manejar documentos extensos.

Pros y contras

Pros:

- Excelente para la lectura y análisis de textos largos.

- Resúmenes precisos y detallados.

Contras:

- No tiene conexión a internet.

- No disponible en todos los países.

- Limitado en funcionalidades adicionales.

Costo

$20/mes. En su version Pro

Gemini de Google

Capacidades y características

Gemini, desarrollado por Google, es la evolución de Google Bard y utiliza el modelo de lenguaje Lambda. Ofrece generación y análisis de imágenes, y conexión a internet.

- Generación de imágenes: Puede crear imágenes basadas en descripciones textuales.

- Visión y voz: Procesa texto, imágenes y voz.

- Conexion con Google Workspace: Actualmente Gemini, al ser un producto de google tiene la capacidad de conectarse con otras aplicaciones de la suit de Google Workspace como Gmail, Google Drive o Youtube. Lo cual ofrece una ventaja de competitividad a la hora de mejorar la productividad del usuario y le permite pedirle directamente busquedas de archivos conectados en Drive, resumenes de correos directos del mail del usuario y visualizaciones y resumenes de videos de youtube.

Pros y contras

Pros:

- Excelente para la lectura y análisis de textos largos.

- Resúmenes precisos y detallados.

- Conexion a internet con datos más precisos

- Conexion con la suit de Google Workspace (G-mail, Google Drive, Youtube)

Contras:.

- No disponible en todos los países.

- Limitado en funcionalidades adicionales.

Costo

$24/mes. En su version Pro

En resumen: ¿Cual es el mejor ChatBot de IA?

Comparativa Final: Modelos LLM según parámetros técnicos y de uso

- Mejor para procesamiento multimodal: GPT-4 (ChatGPT).

- Mejor relación costo-rendimiento: GPT-4o mini.

- Mejor integración con herramientas de productividad: Microsoft Copilot.

- Mejor para análisis de textos largos: Claude de Anthropic.

- Mejor para generación de imágenes y conexión a internet: Gemini de Google.

- Ventana de contexto: 128,000 tokens

- Procesamiento multimodal: Si (Texto, imágenes y Audio)

- Costo: $20/mes

- Conexion a internet: Si

- Ventana de contexto: 64,000 tokens

- Procesamiento multimodal: Si (Texto, imágenes)

- Costo: $5 por millón de tokens de entrada

- Conexion a internet: No

- Ventana de contexto: 128,000 tokens

- Procesamiento multimodal: Si (Texto, imágenes, audio)

- Costo: $15 centavos de dolar por millón de tokens de entrada

- Conexion a internet: No

- Ventana de contexto: NA

- Procesamiento multimodal: Si (Texto, imágenes)

- Costo: Gratis con el ecosistema de Microsoft 365

- Conexion a internet: Si

- Ventana de contexto: 100,000 Tokens

- Procesamiento multimodal: No (Solo Texto)

- Costo: $12/Mes en su version Pro

- Conexion a internet: No

- Ventana de contexto: NA

- Procesamiento multimodal: Si (Texto, imagenes, Audio)

- Costo: $24/Mes en su version Pro

- Conexion a internet: Si

Esperamos que esta guía te haya ayudado a comprender mejor las capacidades y características de los principales modelos de IA en 2024.

Como puedes ver, cada uno tiene sus ventajas y desventajas, por lo que la elección final depende de tus necesidades específicas y del uso que planeas darle.

¡No dudes en explorar y experimentar con estas herramientas para descubrir cuál se adapta mejor a ti!

Preguntas que quizás te estás haciendo

¿Qué es la ventana de contexto y por qué es importante?

La ventana de contexto se refiere a la cantidad de información previa que un modelo puede recordar y utilizar al generar una respuesta. Es crucial porque una mayor ventana de contexto permite al modelo mantener la coherencia en textos largos y ofrecer respuestas más precisas.

¿Qué significa interacción multimodal en los modelos de IA?

La interacción multimodal significa que el modelo puede procesar y generar no solo texto, sino también imágenes, y en algunos casos, audio y video. Esto amplía las capacidades del modelo, haciéndolo más versátil para diversas aplicaciones.

¿Qué son los tokens y por qué son importantes en los modelos de IA?

Los tokens son las unidades básicas que los modelos de IA utilizan para procesar y generar texto. Un mayor número de tokens permite generar respuestas más detalladas y complejas. En promedio, 1,000 tokens equivalen a unas 750 palabra

¿Qué son las alucinaciones en los chatbots de IA?

Las alucinaciones se refieren a respuestas generadas por el modelo que son incorrectas o no tienen fundamento en los datos proporcionados. Estas pueden ser problemáticas porque pueden inducir a error a los usuarios, afectando la fiabilidad del modelo.

¿Qué avances tendra la IA en la salud?

La IA mejorará los diagnósticos y tratamientos médicos, permitiendo una medicina más precisa y personalizada. Sin embargo, es crucial manejar adecuadamente la privacidad y seguridad de los datos médicos para proteger a los pacientes.

¿Cuál es la diferencia entre GPT-4 y GPT-4o mini?

GPT-4 es la versión más avanzada de ChatGPT, con capacidades multimodales y una gran ventana de contexto. GPT-4o mini es una versión más asequible y optimizada para aplicaciones que necesitan bajo costo y baja latencia, manteniendo un rendimiento notable.

Soy una apasionada del mundo digital. Me encanta ver cómo la tecnología ayuda a las personas a conectarse y a tener una vida mejor. Por esto es que trabajo en el mundo de la tecnología, mejorando la experiencia de usuario de sitios web de e-commerces. Identifico oportunidades potenciales en estos sitios web, con la meta de potencializar los resultados de ventas y de ayudar a que los usuarios de estos sitios, encuentren más fácilmente los productos que desean.

Blogs realacionados

Impulsa Tu Marketing con Prompts para IA Poderosos y Efectivos

Aquiere prompts de marketing diseñados para capturar la atención y generar acción, perfectos para cualquier estrategia de negocio.

Síguenos

Podcast y youtube

porcontar

- Quién es Porcontar

- Sobre Ximena

- Sobre Luisa

- Medios de comunicación